年々進歩する自動車向けのテクノロジー。日本国内でも2020年4月に、運転自動化レベル3に相当する、特定の条件下で運転操作の自動化が解禁されました。車を自動運転するために必要な技術のなかでも重要なのが物体認識です。今回は、完全自律走行車両の実現を目指す、画像処理AI技術のパイオニアであるStradVision(ストラドビジョン)社の技術アドバイザー 星 泰彦 氏に、自動車向け物体認識AIソフトウェアでできることや、人の眼による認識との違いなどについてお聞きしました。

Engineering advisor(技術アドバイザー)

日本の大手SoC(組み込みチップ)メーカーで、自動車用SoCの開発に従事したのち、2021年6月よりストラドビジョン株式会社のアドバイザーに就任。自動車用SoCにストラドビジョンのソフトウェアを採用するための仕様策定やメーカーとの交渉などを担当。

ドイツの高級車メーカーも採用する物体認識AI

――ストラドビジョン社はグローバルに展開する、自動車向け物体認識ソフトウェアの提供会社と聞いています。どのような事業を展開されていますか?

星 氏:StradVisionは、自動運転のための先進運転支援システム(ADAS)とディープラーニングベースの物体認識ソフトウェア「SVNet」を開発する、韓国生まれのスタートアップです。 2014年にAIベースのコンピュータービジョンと画像処理の分野の専門家によって設立され、現在、ソウル、サンノゼ、東京、ミュンヘンに拠点を構えていて、メンバーは170人ほどです。これまでに世界9社の自動車メーカーと、50を超える車種にSVNetを供給する契約を締結しています。うち1社はドイツの高級車メーカーですよ。

自動車は、人々の生活に直結する非常に重要な製品で、間違いがあってはならない領域でもあります。 StradVisionの目標は、人の安全を完全に保証し、なおかつ量産に耐えうるコスト効率のいいAIソフトウェアを提供することです。

私は前職で日本のSoC(組み込みチップ)メーカーにいて、自動車用SoCの開発を担当し、5年ほど前からStradVisionとも仕事をしていました。現在はソフトウェアやハードウェアの知識を活かした技術アドバイザーとして、日本のSoCメーカーさんとのやりとりをしています。

自動車用SoCの専門家、星氏

――多くの自動車メーカーが自律走行システムの実現を目指しています。これまでの、ADAS(先進運転支援システム)との違いや自動運転レベルの現状などをお教えいただけますか?

星 氏:ADASは、運転中の環境を認識・判断することで、ドライバーの操作を最小限に抑えながら安全な運転を支援します。たとえば、前を向いているカメラで危険物を認識したら、ブレーキをかけるというのが代表的な役割です。このほかにも駐車補助や車線維持、死角検出、運転者の眠気防止、スピード調節機能も含まれます。

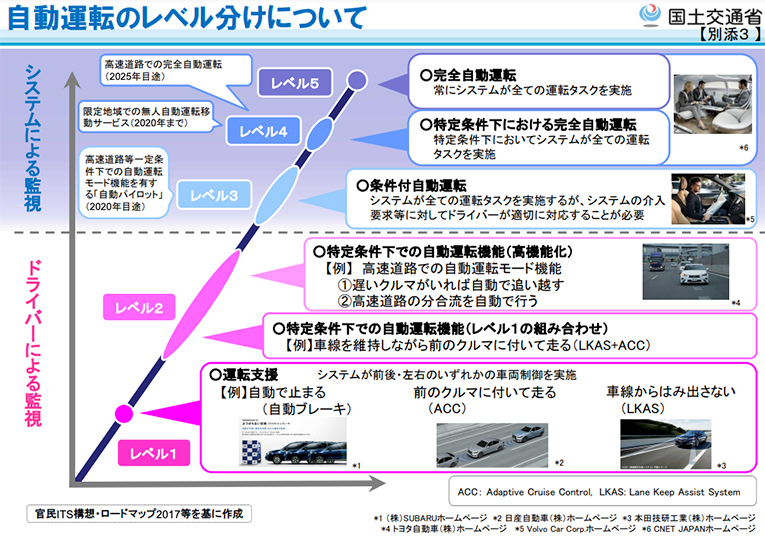

一方で、自律走行は人間のドライバーの操作をなくすことを目的にしているので、止まるだけでなく、安全に走行しなければなりません。米国SAE(Society of Automotive Engineers)が定める自動車の自動化レベルがありまして、ADASはレベル0〜3、自律走行は3〜5レベルに相当します。

自動運転のレベル分け(国土交通省資料より)

自律走行技術は、最近では物流輸送、または一定区間内で運営するシャトルバスなどで導入されていますが、一般車両でレベル5の完全な自律走行の実現には、自動車業界が解決すべき技術的、事業的難題があります。

現在、障害物や人を検出する技術はあります。自律走行をするには、検出した物や人がそのあとどうなるかを予測しなければなりません。人の場合は、運転中に横断歩道の脇に人がいるのを確認したら、その人が歩道を渡るのかどうかを予測しながら車を操作しますね。現在のところコンピューターだけでは、そのような予測・判断が難しいのです。

ヘラジカ、牛、スカンクなど、地域によっては動物も検出

――なるほど。確かに止まるタイミングよりも、微妙な状況でこのまま走っていて良いのかどうかを判断するほうが難しそうですね。では、物体認知システムSVNetの仕組みをお教えください。人の眼での判断とどう違うのでしょうか。

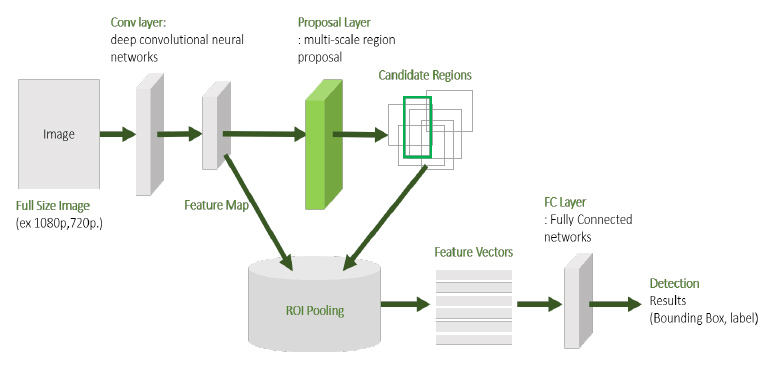

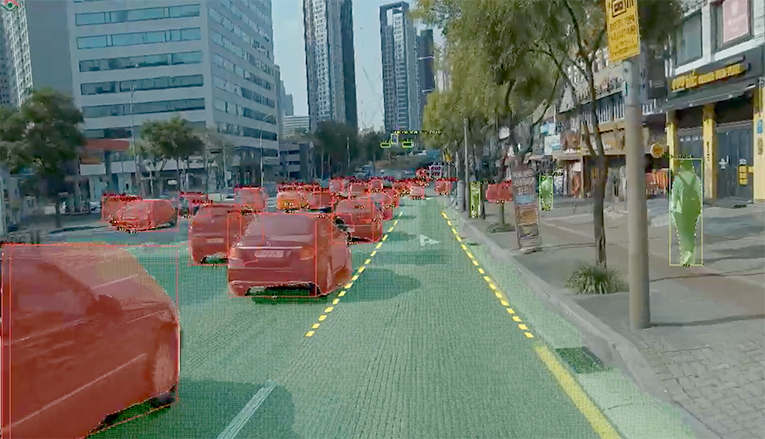

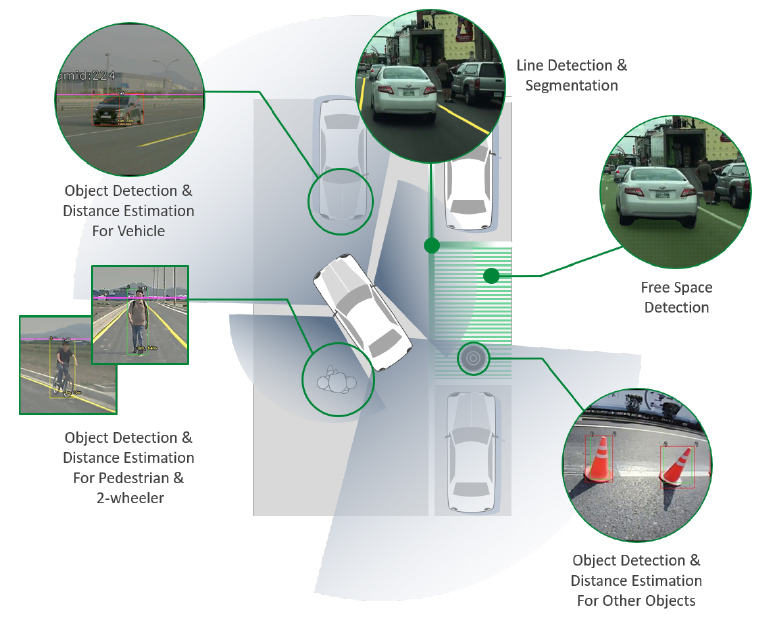

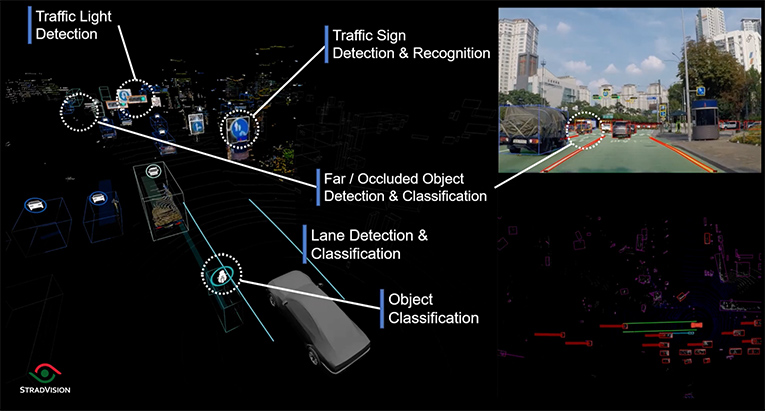

星 氏:SVNetは、AI技術を使用して車載カメラからの映像を分析し、さまざまな物体を認識するソフトウェアです。人でいうと、視神経みたいなものですね。人の目と同様に、可視光を透過した画像上の物体を認識します。道路に存在するほかの車両や歩行者、動物などのほか、車線や信号機、標識などの道路システムに関連する情報も識別して、オブジェクトボックスで示します。

カメラの情報からAIが物体を認識・判別した結果を返す

自動車が走行中のさまざまな物体や生物を認識し、分類されたオブジェクトボックスで示す

運転時に撮影したビデオとAI学習ソフトウェアを通じて、さまざまな物体の情報と分類を学習して精度を高めています。物体認識のAIモデルはいろいろありますが、SVNetは車に搭載するチップに組み込んで動作できるのが特徴です。パソコンやスマートフォンに使われているCPUの計算能力を人の脳レベルとするならば、車載チップは昆虫の脳ほどの計算能力しかありません。しかし、SVNetは、低コストのチップの能力を最大限に引き出し、優れた認識能力を提供できます。しかも、14のプラットフォームに対応しているので、メーカーさんの要望に応じてカスタマイズできます。

人の眼と大きく違う点は、車の前方だけでなく周囲にカメラを設置して、死角をなくせることですね。

前後左右にカメラを設置することで、車の周囲の情報を認識できる

SVNetには30以上の機能があります。主な機能は物体検出に車線検出、空間検出、距離推定、サラウンドビュー監視、ナンバープレート検出、道路標識検出、動物検出、交通標識認識、信号機検出などです。

SVNetはこれらの認識、検出、分類機能までを提供します。それで、SoCメーカーさんなどがほかのデバイスやソフトウェアと組み合わせて、ADASや自律運転機能を実現するわけです。たとえば、衝突警告や緊急ブレーキ、クルーズコントロール、自動駐車などですね。

――メーカーさんの要件に応じて、分類するものも変わってくるのでしょうか? たとえば、地域によって天候や地理条件などで認識すべきものは変わりますか?

星 氏:SVNetは、数多くの画像とビデオデータで物体について学習しています。しかし、弊社のデータだけでは要件に応じた認識ができない場合がありますので、お客様に何を検出したいかのご要望をお聞きして、そのために必要な映像データも提供いただいています。

ですから、地域によって認識が必要な動物などのデータが変わります。たとえば、カナダだとヘラジカに対応しなければなりません、ぶつかってしまうと車が大破してしまうからです。インドではたくさんの牛が車道を歩いています。北米などに生息するスカンクも衝突してしまうと、異臭で車が使えなくなるので、検出する必要があるでしょう。

道路にたびたび出現する牛など、地域の条件に応じた認識も要件に含まれる

AIの学習でちょっと難しいのが天候です。何千時間もの録画データが必要になりますが、対象地域の全ての天候でのデータを自分たちで用意するのが難しいんですね。ここはお客様にもご協力いただく必要があります。

録画データを学習するには、映像のなかの物体を認識して、それが何であるかをラベリングしていく必要があります。これについては自社で自動処理するツールを持っていて、97%のラベリングが自動でできるようになっています。これもコスト効率をよくする要因となっていますね。

カメラとLiDARによって人の能力を超えた物体認識を実現

――カメラからの認識だと、暗いところではうまく認識できない場合もあるのではないでしょうか? レーザーによる検出を行うLiDARの技術も組み合わせた取り組みをしているそうですね。

星 氏:カメラは可視光によってさまざまな物体の形状や色を認識できますので、物体の分類や車線検出などが得意です。LiDARは、赤外線などのレーザーの反射を使用して物体を認識する技術で、明かりがなくても物体までの距離を非常に正確に測定できます。弊社では現在、LiDAR技術を持つビューロン・テクノロジー社と共に、お互いの利点を組み合わせて、より高い精度の認識を目指す「センサーフュージョン」を開発しています。

カメラ画像を通じて収集されたオブジェクトの詳細情報をLiDARセンサーによって描画された3D点群と統合して、周囲の環境を正確に認識することを目指しています。正確な距離を測る点では、人の能力を遥かに超えていますね。

センサーフュージョンのイメージ画面。右上がカメラの情報で、右下がLiDARの情報

カメラとLiDARにはそれぞれ一長一短があります。情報の取得サイクルでは、カメラなら秒間30フレーム以上で情報を取得できますが、LiDARは秒間15フレーム程度と少ないです。

また、赤外線を利用するLiDARは、夏の暑いときにノイズが入ることもありますね。雪が激しく降っている場合もLiDARは測れなくなるリスクがあります。カメラの場合はある程度見えていればいいのですが、そもそも人が運転できないような悪天候下では車の走行自体が危険です。

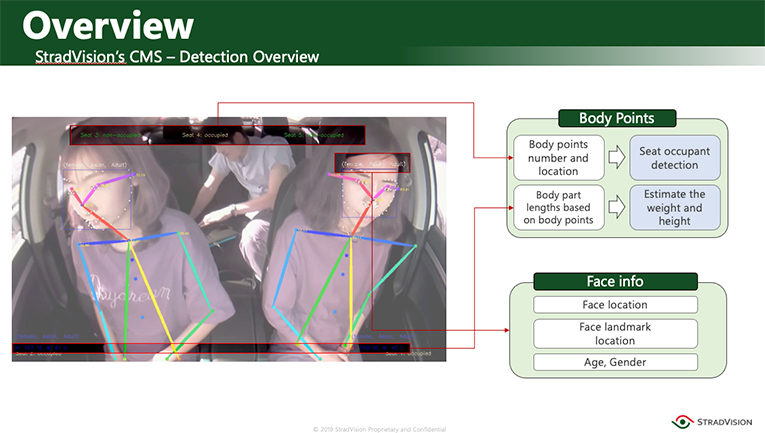

――続いて、DMS(ドライバーモニタリングシステム)についてもお教えください。

星 氏:DMSはドライバーの運転状態を確認するためのソリューションです。ルームミラー周辺に設置されたカメラを介して車内をリアルタイムでチェックします。居眠り運転などを警告したり、ブレーキをかけたりするような用途で使われています。

自律運転のレベル4クラスになると、ドライバーが運転を監視しなくてもよくなります。寝ていても、よそ見をしていてもいいのですが、システムが自律運転状態からドライバーに運転を渡してもいいかどうかを判断するために、ドライバーを常時モニタリングすることが必要になります。

自律運転レベル4の実現には、車内の人の体や顔の状態を認識する必要もある

また、最近は、Euro NCAP(New Car Assessment Programme)という欧州の自動車の取り決めで、ドライバーだけではなく、車内にいる人の状態のモニタリングを求められるようになっています。子供が車内に取り残されるのを防ぐような目的にも使われるためです。

AIなど、車載システムの安心・安全は自動車業界全体で確立

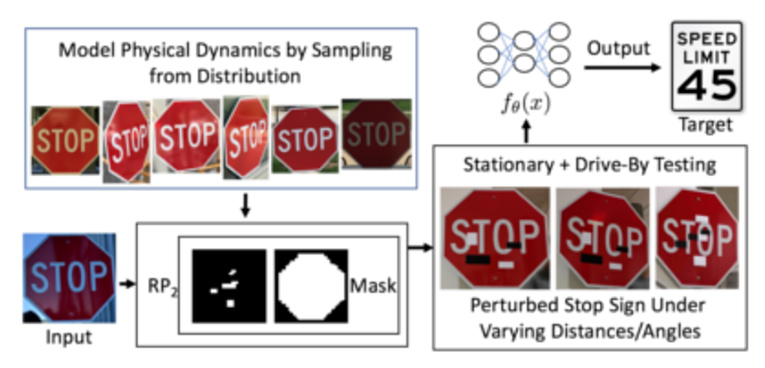

――ちょっと意地悪な質問なのですが、飲食店の看板(ロゴ)を道路標識と誤認識したり、標識に落書きしたりするなどの攻撃にAIは対応できるのでしょうか?

星 氏:質の良い学習データがあれば、対応できるのではないでしょうか。看板と標識の誤認識については、正しい情報、そうでない情報をできる限り集めて学習することと、チェックを入念に行うことが重要です。弊社では独自のツールを使って誤認識のチェックをしています。

標識の物理的なハッキングは、たとえば「止まれ」とあるのに「80キロで進め」といった誤った認識結果を出させるものだと思いますが、物体認識のAIだけでなく、別の機能やシステムを組み合わせた、車に盛り込むシステム全体で何重にもチェックして解消することができます。たとえば、高精度の地図情報を参照する方法です。たとえ物体認識で標識が誤認識されたとしても、地図データに停止や制限速度の情報があればそちらを参考に運転を判断するような処理にすることで、回避できるのではないかと思います。

「止まれ」の標識に落書きをして「制限速度45マイル」に誤認識させる物理ハック

(論文「Robust Physical-World Attacks on Deep Learning Models」より)

――ちなみに、SoCに組み込まれたSVNetを取り出して解析し、攻撃に使われる恐れはありますか?

星 氏:現実的なことで言いますと、学習したデータを改造するのは非常に難しいです。SoCに入っているデータの中身はわからないように暗号化などがなされていますし、安全対策はメーカーさん側で何重にも行っています。車はガソリンで走りますし、電気自動車も巨大なリチウムイオンバッテリーを積んでいますので、よく考えると危険なものですよね。自動車における安心安全の対策が必須なのと同様、SoCのデータについてもリスク管理はなされています。

――御社としては、今後どのように車の機能を高めていきますか? また、この記事はエンジニアさんに向けたものでもあります。エンジニアが活躍できるチャンスはありますか?

星 氏:これからは、物体認識だけでなく、その先の走行可能かどうかの判断もしていきたいと考えています。StradVisionの強みは、SoCメーカーさんが作ったデバイスの性能を究極に引き出して動作させることですね。大手SoCメーカーさんが提供するツールだけでは、デバイスの性能を存分に引き出せないんですよ。そこで、弊社ではオリジナルのツールを作って、ソフトウェア的にハードウェアの性能を高められます。理系でゴリゴリにハードウェアが好きな人には面白いところだと思いますね。

私が前職でStradVisionと仕事を始めた5年前、メンバー数は40名くらいだったのですが、今は170名と急速に成長しています。現在、日本でも採用を強化していますが、AIを研究している方は、華やかな印象のIT業界に進むことが多く、組み込みの業界にはなかなか来られないんですよね……。組み込みに関心のあるエンジニアが非常に少なくなっているのが実情で、少し寂しく思っています。

しかし、モビリティ分野は成長過程にあり、StradVisionはすでに業界でこの分野の先駆者としてのポジションを確立しているので、とてもいいと思います。特にドイツではキープレイヤーの一社になっていますので、日本市場でも存在感を示していきたいですね。エンジニアの報酬も高い水準のようですので、いっしょにチャレンジしませんか(笑)。

――星さん、楽しいお話をありがとうございました!